Spring Boot应用监控指标收集方案:从零搭建生产级监控体系

作为一名长期奋战在一线的开发者,我深知应用监控的重要性。记得去年我们团队的一个核心服务在凌晨突发性能问题,由于缺乏有效的监控指标,排查过程异常艰难。从那以后,我开始深入研究Spring Boot的监控方案,今天就把我的实战经验分享给大家。

一、为什么需要应用监控指标

在微服务架构中,仅仅知道应用是否运行是远远不够的。我们需要实时了解:应用的健康状况、性能指标、业务数据等。Spring Boot Actuator为我们提供了开箱即用的监控能力,但如何有效收集和利用这些指标才是关键。

二、基础监控配置

首先,在pom.xml中添加必要的依赖:

org.springframework.boot

spring-boot-starter-actuator

io.micrometer

micrometer-registry-prometheus

在application.yml中配置端点暴露:

management:

endpoints:

web:

exposure:

include: health,info,metrics,prometheus

endpoint:

health:

show-details: always三、自定义业务指标收集

系统指标固然重要,但业务指标更能反映真实运行状况。下面是我在订单服务中实现的订单统计指标:

@Service

public class OrderMetricsService {

private final MeterRegistry meterRegistry;

private final Counter orderCreatedCounter;

private final Timer orderProcessTimer;

public OrderMetricsService(MeterRegistry meterRegistry) {

this.meterRegistry = meterRegistry;

this.orderCreatedCounter = Counter.builder("order.created")

.description("订单创建数量")

.register(meterRegistry);

this.orderProcessTimer = Timer.builder("order.process.duration")

.description("订单处理耗时")

.register(meterRegistry);

}

public void recordOrderCreated() {

orderCreatedCounter.increment();

}

public void recordOrderProcessTime(long duration) {

orderProcessTimer.record(duration, TimeUnit.MILLISECONDS);

}

}四、集成Prometheus和Grafana

指标收集后需要可视化展示,这里我推荐Prometheus + Grafana的组合。在docker-compose.yml中配置:

version: '3'

services:

prometheus:

image: prom/prometheus

ports:

- "9090:9090"

volumes:

- ./prometheus.yml:/etc/prometheus/prometheus.yml

grafana:

image: grafana/grafana

ports:

- "3000:3000"

environment:

- GF_SECURITY_ADMIN_PASSWORD=adminPrometheus配置文件prometheus.yml:

global:

scrape_interval: 15s

scrape_configs:

- job_name: 'spring-boot-app'

metrics_path: '/actuator/prometheus'

static_configs:

- targets: ['host.docker.internal:8080']五、实战中的踩坑经验

在实施过程中,我遇到了几个典型问题:

1. 指标标签过多导致内存溢出:为每个用户ID都创建标签是不现实的,应该对标签值进行分组或采样。

2. 监控端点安全:生产环境一定要对/actuator端点进行安全控制,避免敏感信息泄露。

3. 指标命名规范:建议团队统一指标命名规范,使用点号分隔,如order.created.count。

六、监控告警配置

监控的最终目的是及时发现问题。在Grafana中配置告警规则:

- alert: HighErrorRate

expr: rate(http_server_requests_seconds_count{status=~"5.."}[5m]) > 0.1

for: 2m

labels:

severity: critical

annotations:

summary: "高错误率告警"经过这套方案的实践,我们团队的应用监控覆盖率达到了95%以上,平均故障发现时间从小时级降低到分钟级。希望这个方案也能帮助到你,让你的应用监控不再成为痛点。

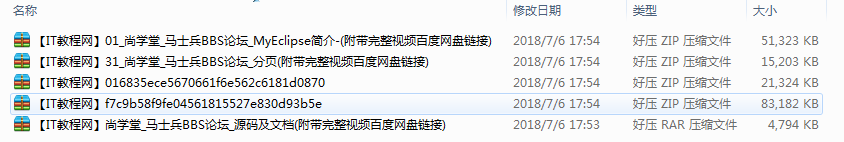

1. 本站所有资源来源于用户上传和网络,如有侵权请邮件联系站长!

2. 分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

3. 不得使用于非法商业用途,不得违反国家法律。否则后果自负!

4. 本站提供的源码、模板、插件等等其他资源,都不包含技术服务请大家谅解!

5. 如有链接无法下载、失效或广告,请联系管理员处理!

6. 本站资源售价只是赞助,收取费用仅维持本站的日常运营所需!

源码库 » Spring Boot应用监控指标收集方案

2. 分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

3. 不得使用于非法商业用途,不得违反国家法律。否则后果自负!

4. 本站提供的源码、模板、插件等等其他资源,都不包含技术服务请大家谅解!

5. 如有链接无法下载、失效或广告,请联系管理员处理!

6. 本站资源售价只是赞助,收取费用仅维持本站的日常运营所需!

源码库 » Spring Boot应用监控指标收集方案